Daily Trend [11-21]

【1】Emu Video: Factorizing Text-to-Video Generation by Explicit Image Conditioning

【URL】http://arxiv.org/abs/2311.10709

【Time】2023-11-17

一、研究领域

text-to-video generation

二、研究动机

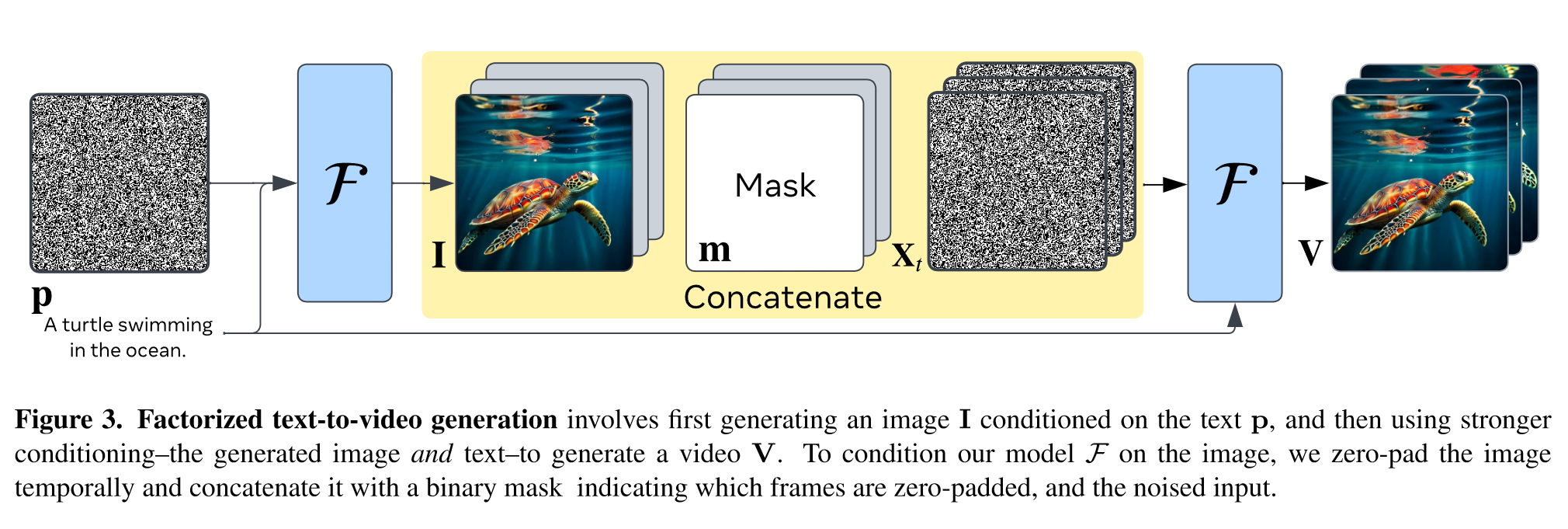

提出假设:加强 conditioning signal 对于高质量视频生成很重要,因为视频本质上是时间序列。于是提出 EMU VIDEO, 通过显式中间图像生成步骤来加强基于扩散的文本到视频生成的 conditioning。具体来说,将文本到视频的生成分解为两个子问题:(1)根据输入文本提示生成图像; (2)基于图像和文本的更强条件生成视频。

三、方法与技术

基本pipeline:

(1)给定文本提示 p 并生成第一帧(图像):使用预训练的 T2I 模型初始化条件扩散模型 F,使之能够根据给定 prompt 生成 image。特别地,在 F 中加入了可学习的 temporal parameters,在每个空间卷积后面添加了 1D 时间卷积,在每个空间 attention 后面添加了 1D 时间 attention, 原始的空间卷积和注意力层独立地应用于每个 T 帧并保持冻结。

(2)利用文本提示和图像 conditioning 生成视频的 T 帧:以 prompt 和采样的第一帧 image 为 condition,训练 F 生成接下来的 T 帧。特别地,向条件扩散模型 F 中加入 image conditioning 时,不是通过 image embedding cross attention 的形式,而是直接将 condition image (即 first frame)concate 到 input noise 上。

特别的设计:

(1)Zero terminal-SNR noise schedule:注意到 high-resolution video frames 的生成过程中存在严重的非零信噪比问题,即在训练时,噪声表留下一些残留信号,即使在最终扩散时间步长 N 也具有非零信噪比 (SNR)。于是,当从没有真实数据信号的随机高斯噪声中采样时,会阻碍扩散模型在测试时泛化。因此,作者提出的解决方案是通过缩放 noise schedule 并设置最终的 αN = 0 ,使得训练期间终端时间步 N 处的 SNR 为零。

(2)Interpolation model:使用与 F 结构相同的插值模型 I,将 T 帧的低帧率视频转换为 Tp 帧的高帧率视频。该模型在具有 Tp 帧 的视频 clips 上进行训练,其中 T 帧作为输入送入。为了提高效率,我们从 F 初始化 I,并且只训练用于插值任务的模型 I 的时间参数。

(3)Simplicity in implementation:在推理时,给定文本提示,在没有时间层的情况下运行 F 来生成图像 I。然后,使用 I 和文本提示作为 F 的输入,直接以高分辨率生成 T 视频帧。接下来,可以使用 I 来提高视频的 fps。

四、总结

很不错的工作,demo 也很棒。并且这还是笔者第一次看到 Zero terminal-SNR 问题的解决方案。之前训练 diffusion 模型的时候也一直被这个现象困扰。